Le deuxième « Forum mondial sur l’éthique de l’intelligence artificielle : transformer la gouvernance de l’IA » a eu lieu les 5 et 6 février 2024 en Slovénie.

En effet, la bonne gouvernance de l’intelligence artificielle (IA) est un défi majeur de notre époque, qui nécessite un apprentissage basé sur les bonnes pratiques émergeant des différentes juridictions à travers le monde. Les changements rapides engendrés par cette évolution suscitent également d’importantes inquiétudes éthiques et déontologiques. Aucun autre domaine ne requiert autant une boussole éthique que celui de l’intelligence artificielle, car ces technologies polyvalentes transforment profondément notre manière de travailler, d’interagir et de vivre.

Alors que la déontologie désigne l’ensemble des règles et devoirs qui régissent une profession, la conduite de ceux qui l’exercent, les rapports entre ceux-ci et leurs clients et le public, nous pouvons aisément identifier les menaces que lui oppose l’IA, notamment dans le domaine du droit. En effet, la déontologie est mise à rude épreuve lorsque l’intelligence artificielle menace les droits fondamentaux des individus (I) et le concept de propriété intellectuelle (II).

La menace du respect

des droits fondamentaux

L’intelligence artificielle représente une avancée technologique majeure, mais son essor rapide soulève des préoccupations quant aux risques d’atteinte aux droits fondamentaux. A mesure que l’IA s’intègre dans divers domaines tels que la surveillance, l’emploi, la prise de décisions etc, les questions liées à la vie privée, à la discrimination et à la transparence deviennent des sujets de préoccupation majeurs.

La menace du droit à la protection de la vie privée

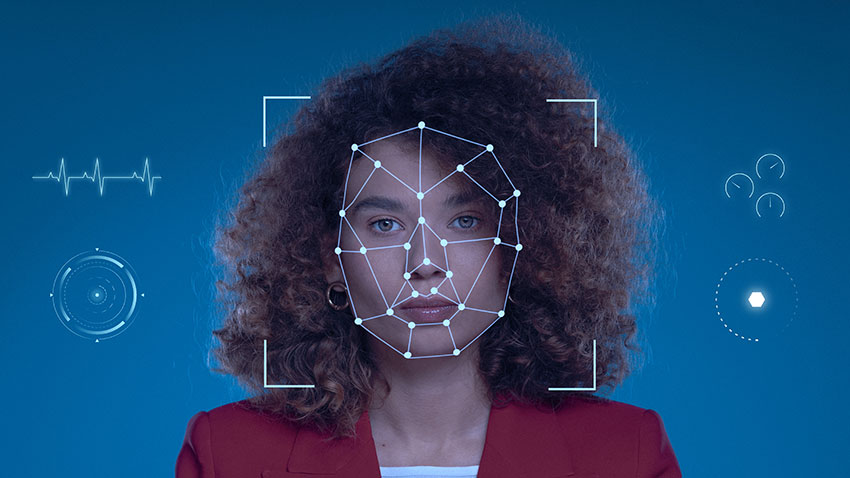

L’un des principaux droits fondamentaux qui est menacé par l’IA est celui du droit à la protection de la vie privée. En effet, les systèmes d’IA souvent alimentés par de vastes ensembles de données, peuvent collecter, analyser et interpréter des informations personnelles de manière exhaustive. Cela soulève des questions sur le droit des individus à contrôler leurs données et leur capacité à maintenir une sphère privée. Des applications telles que la surveillance de masse par le biais des caméras de sécurité équipées de technologies d’analyse d’image avancées peuvent potentiellement violer le droit à la vie privée, en enregistrant et analysant les mouvements des individus sans leur consentement.

Le risque inhérent à l’IA de discrimination

Ensuite, la discrimination intrinsèque des systèmes d’IA est une autre source de préoccupation majeure. Les algorithmes peuvent refléter et perpétuer les biais présents dans les données sur lesquelles ils sont formés. Cela peut se traduire par des discriminations injustes dans les domaines cruciaux tels que le recrutement, les prêts, ou même le système judiciaire. Par exemple, si un algorithme est formé sur des données historiques biaisées, il peut reproduire ces préjugés en favorisant certains groupes au détriment d’autres, amplifiant alors les inégalités préexistantes.

Néanmoins, si l’on souhaitait éviter que l’IA reproduise les stéréotypes sociaux et culturels auxquels elle est soumise, alors il faudrait que le créateur lui-même modifie les systèmes de l’IA. Mais alors, comment s’assurer que le créateur est à même de choisir quelles valeurs sont à intégrer, quels biais et stéréotypes sont bons ou mauvais.

Le risque de manque de transparence dans le traitement des données

La transparence et la responsabilité sont également des aspects essentiels de la déontologie dans l’utilisation de l’IA. Les décisions prises par des systèmes automatisés peuvent souvent sembler opaques, car les mécanismes internes des algorithmes sont complexes et difficiles à comprendre. Cela se pose comme un défi au droit de l’information, car les individus peuvent se retrouver dans l’incapacité de comprendre ou contester les décisions qui les concernent. Une transparence accrue dans la manière dont les systèmes d’IA prennent des décisions est cruciale pour garantir la responsabilité et permettre une supervision adéquate.

A cet égard, le RGPD (Règlement Général sur la Protection des Données) encadre strictement les processus de prise de décision entièrement automatisés, et l’article 22 du règlement énonce notamment que les individus ont le droit de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé, produisant des effets juridiques ou les affectant de manière significative. Ils ont le droit d’exiger une intervention humaine dans le processus.

En effet, pour atténuer ces risques, il est impératif de mettre en place des garde-fous et des règlementations appropriées.

Dans ce contexte, les états membre de l’Union Européenne ont adopté le 2 février 2024 le texte définitif du règlement sur l’intelligence artificielle (IA Act), qui sera soumis au vote du parlement à la mi-avril. Ce texte prévoit une règlementation des systèmes d’intelligence artificielle (SIA) selon un classement par niveau de risque, soit précisément 4 niveaux de risques.

Les risques sont qualifiés d’inacceptables, élevés, limités ou minimaux en fonction de leur nature. Par exemple, alors que le scoring social et l’identification biométrique ou encore la reconnaissance des émotions dans les milieux professionnels et éducatifs, sont qualifiés d’inacceptables, conformément à l’analyse de la Cour européenne des droits de l’homme (CEDH) qui avait déjà recommandé de les interdire, le scoring bancaire est catégorisé comme élevé tandis que les filtres anti-spam sont qualifiés de limités.

De la classification de risque dépendent les obligations qui incombent au fournisseur ou à l’utilisateur de l’IA. Par exemple, alors que le risque « inacceptable » rend l’usage interdit, le risque « élevé » rend obligatoire des mesures de mise en conformité du SIA (enregistrement des activités, information des utilisateurs, intervention humaine…). Le risque limité implique quant à lui des mesures simplifiées. Afin d’en assurer le respect par tous les opérateurs SIA conçus au sein de l’UE ou simplement traitant sur le marché européen, l’IA Act prévoit des sanctions financières pouvant s’élever jusqu’à 30 millions d’euros ou 7% du chiffre d’affaires annuel consolidé.

En outre, la Commission nationale consultative des droits de l’homme CNCDH recommande elle aussi de faire peser sur les utilisateurs d’un système d’IA des exigences en mesure de garantir le respect des droits fondamentaux : une étude d’impact, une consultation des parties prenantes, une supervision du système tout au long de son cycle de vie.

L’IA Act, voté le 2 février soit quelques semaines après que le New York Times ait poursuivi Open AI, le 23 décembre 2023, pour violation de droits d’auteur, met également l’accent sur la nécessité de protection de la propriété intellectuelle.

La menace du respect de la propriété intellectuelle

La difficile mise en application du respect des droits d’auteurs

L’intégration croissante de l’intelligence artificielle dans notre quotidien soulève également des préoccupations majeures en ce qui concerne les implications sur le droit d’auteur. La matière première essentielle à l’IA est la donnée. Cependant, l’accès, l’utilisation et la valorisation de ces données posent des risques significatifs en termes de respect des droits de propriété intellectuelle.

L’apprentissage automatique, fondement de l’IA, repose sur des exemples d’entrées et de résultats attendus, appelés données structurées ou données d’apprentissage. Ce processus permet au système de s’améliorer en permanence, prenant des décisions sans nécessiter une programmation étape par étape. L’analogie avec le mécanisme biologique d’acquisition des facultés cognitives renforce l’idée de l’adaptabilité inhérente à l’IA, mais soulève simultanément des défis liés au respect des droits d’auteur.

Depuis juin 2023, l’entreprise Open AI a fait face à un minimum de cinq plaintes déposées par des auteurs qui l’accusent d’avoir utilisé leurs écrits pour entraîner ses intelligences artificielles, sans obtenir l’autorisation nécessaire ni fournir de dédommagement. Parmi les plaignants, l’Authors Guild, une association rassemblant plus de 14 000 écrivains américains, s’est associée au créateur de Game of Thrones pour exprimer ces griefs. L’actrice Sarah Silverman s’est également jointe au groupe, défendant ainsi ses mémoires. De même, les romanciers et essayistes Jonathan Franzen et John Grisham ont déposé des plaintes liées à l’utilisation non autorisée de leurs œuvres.

La proposition de règlement du Parlement européen et du Conseil sur l’équité de l’accès aux données, émise le 23 février 2022, souligne l’importance de la question de l’accès aux données par l’IA. Outre les données à caractère personnel, la première interrogation à laquelle les concepteurs d’IA doivent répondre concerne la nature des données d’apprentissage nécessaires. S’agit-il de données en libre accès, disponibles en open data, ou sont-elles protégées par le droit d’auteur, les droits voisins, ou encore incluses dans une base de données protégée par le droit sui generis du producteur de bases de données ? Si les données nécessaires sont soumises à des droits de propriété intellectuelle, une deuxième question émerge concernant les modalités techniques d’accès, de reproduction et d’intégration dans le résultat final. Cela soulève des défis complexes en termes de respect des droits d’auteur et nécessite une réflexion approfondie sur les moyens légaux pour faciliter cet accès tout en préservant les droits des titulaires de droits.

La nature du produit résultant de l’utilisation de l’IA est également un facteur déterminant. Les concepteurs doivent se poser la question de savoir si le produit final contient des éléments protégés par le droit d’auteur ou d’autres droits de propriété intellectuelle. Cette évaluation est cruciale pour déterminer la légitimité de l’utilisation des données et orienter la stratégie juridique à mettre en place.

Pour relever ces défis, des solutions juridiques doivent être envisagées, telles que la mise en œuvre de l’exception de fouille de texte et de données, permettant un accès libre à des données protégées dans le cadre de l’apprentissage automatique.

En effet, la France a transposé les dispositions de la directive européenne sur le droit d’auteur de 2019, cela incluant particulièrement les dispositions établissant des exceptions au droit d’auteur pour la fouille de textes et de données. On entend par fouille de textes et de données, la mise en œuvre d’une technique d’analyse automatisée de textes et données sous forme numérique afin d’en dégager des informations, notamment des constantes, des tendances et des corrélations. Il est stipulé que la fouille de textes et de données ne peut être contestée par les titulaires de droits d’auteur, si elle est réalisée “aux seules fins de la recherche scientifique par les organismes de recherche, les bibliothèques accessibles au public, les musées, les services d’archives ou les institutions dépositaires du patrimoine cinématographique, audiovisuel ou sonore”.. Grâce à cette exception, l’utilisation des données pour l’IA peut être faite légalement et sans porter atteinte au droit d’auteur, en étant encadrée et règlementée pour éviter toute dérive.

Les risques que pose l’IA face au droit d’auteur nécessitent une approche équilibrée et réfléchie. La réglementation, telle que la proposition européenne sur l’équité de l’accès aux données, offre un cadre initial, mais il est essentiel de continuer à développer des mécanismes juridiques adaptés pour garantir un juste équilibre entre l’innovation technologique et la protection des droits de propriété intellectuelle.

Le vide juridique concernant la propriété et la responsabilité des IA génératives

La question de la responsabilité des intelligences artificielles génératives se situe au croisement complexe du droit d’auteur français et des caractéristiques propres aux créations produites par ces technologies émergentes.

Le cadre du droit d’auteur en France protège les “œuvres de l’esprit” à condition qu’elles soient considérées comme “originales”. La notion d’originalité implique la présence de l’empreinte de la personnalité de l’auteur, résultant de choix libres et créatifs. Toutefois, deux interrogations majeures se posent en relation avec les IA génératives : premièrement, peut-on attribuer à l’outil IA la qualité d’auteur ? Deuxièmement, les créations engendrées par une IA peuvent-elles être réellement qualifiées d’originales ?

Selon le droit français, seule une personne physique peut revendiquer la qualité d’auteur, avec une exception pour les personnes morales associées aux droits d’auteur relatifs à une œuvre collective. Ainsi, une machine ou un logiciel ne peut être reconnu en tant qu’auteur au sens du Code de la propriété intellectuelle en France.

L’élément déclencheur des créations générées par l’IA reste l’intervention humaine, où un individu donne des instructions à l’outil. Toutefois, la question cruciale se pose : cette personne, en donnant des consignes, peut-elle être considérée comme l’auteur au sens du Code de la propriété intellectuelle ? La réponse semble difficile à affirmer positivement, surtout en ce qui concerne les résultats bruts générés par l’outil. Ces résultats demeurent imprévisibles pour l’utilisateur, car de simples variations de quelques mots-clés peuvent entraîner des variations drastiques dans le contenu généré par l’IA.

Dans le contexte où l’utilisateur n’a pas un contrôle total sur les résultats produits par l’IA, il devient ardu de soutenir que ces résultats portent l’empreinte de sa personnalité. Cependant, une nuance importante émerge lorsque le résultat généré par l’IA est retravaillé par l’utilisateur. Dans ce cas, le travail ultérieur peut bénéficier de la protection du droit d’auteur, pour autant qu’il réponde aux exigences d’originalité du Code de la propriété intellectuelle.

En somme, la responsabilité des IA génératives dans le contexte du droit d’auteur français demeure une question délicate. L’absence de reconnaissance de la machine en tant qu’auteur souligne la nécessité d’explorer des mécanismes juridiques qui prennent en compte la complexité des interactions entre l’humain et l’IA dans le processus créatif, tout en préservant les droits légitimes des parties impliquées.

Face aux enjeux complexes de la déontologie et de l’intelligence artificielle, LEGALPROTECH-AVOCATS demeure engagé à fournir des solutions juridiques adaptées et innovantes. Forts de notre expertise dans ce domaine en constante évolution, nous sommes prêts à accompagner nos clients à naviguer dans les défis juridiques liés à l’IA. Si vous recherchez des conseils juridiques spécialisés pour assurer une utilisation éthique et conforme de l’IA, n’hésitez pas à nous contacter. Nous sommes là pour vous offrir un soutien professionnel et personnalisé, garantissant une approche juridique rigoureuse.

Par Aurélia Jauffrineau et Christelle Reyno